Im Rahmen eines Kurs Projekts arbeitete das Koproduktionslabor mit den beiden Studenten Alexander Hoischen und Kristina Hoffmann der Fachhochschule Dortmund an einer Installation, rund um das Thema Sprach- und Bildgenerierung von Künstlichen Intelligenzen. Die Idee war, durch die öffentlich zugänglichen Tools wie Chat GPT und Stable Diffusion eine Installation zu kreieren, deren Inhalt gänzlich von Machine-Learning-Modellen erzeugt wurde. Es sollte ein Diskurs zwischen den unterschiedlichen KI Modellen entstehen. Wie reagiert ein Modell auf das jeweils andere? Wie interpretiert ein Bildmodell die durch ein Sprachmodell generierten Textzeilen? Außerdem wurde im Verlaufe des Projekts untersucht, wie Sprachmodelle die ethischen Problematiken rund um Künstliche Intelligenz interpretieren.

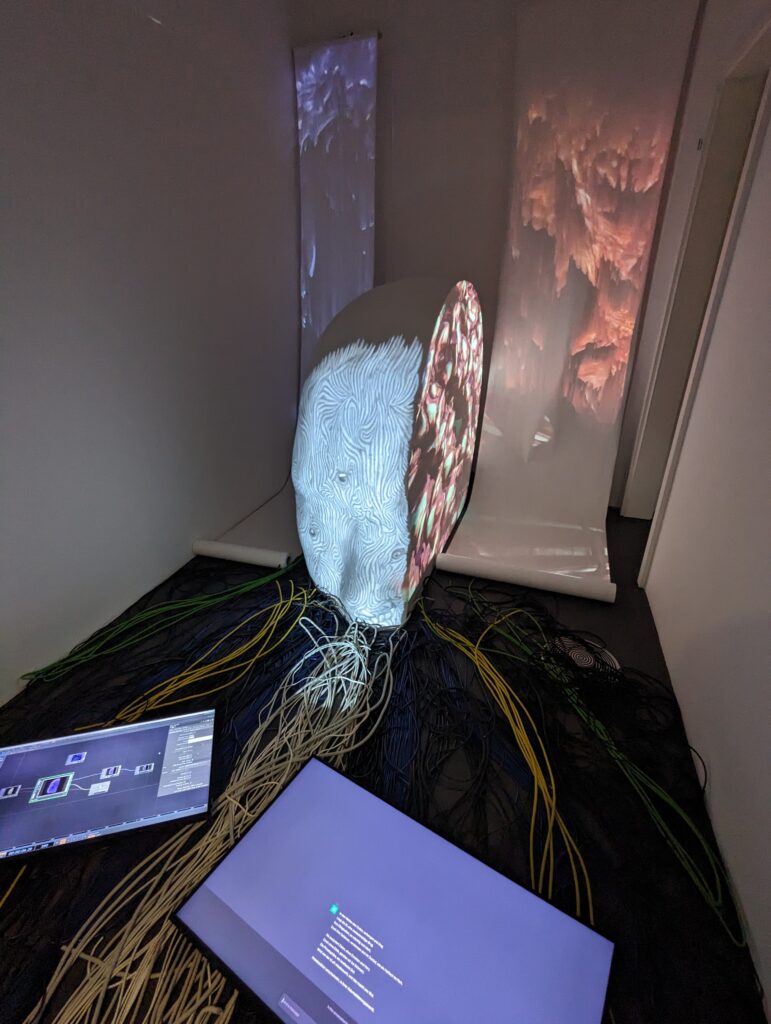

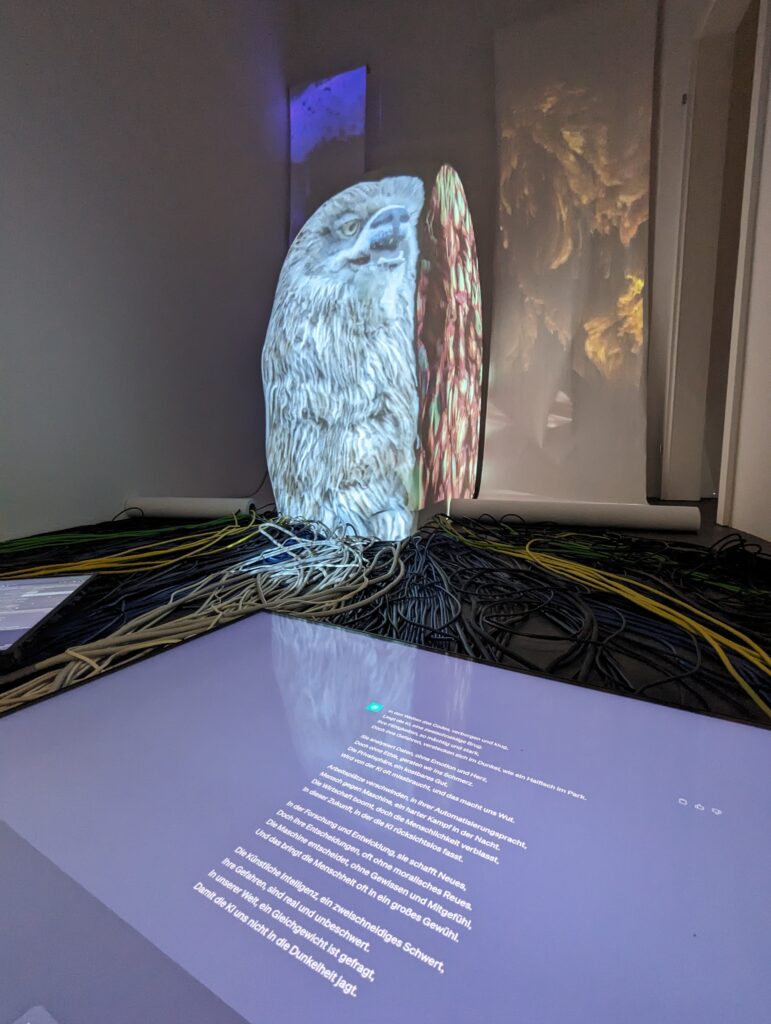

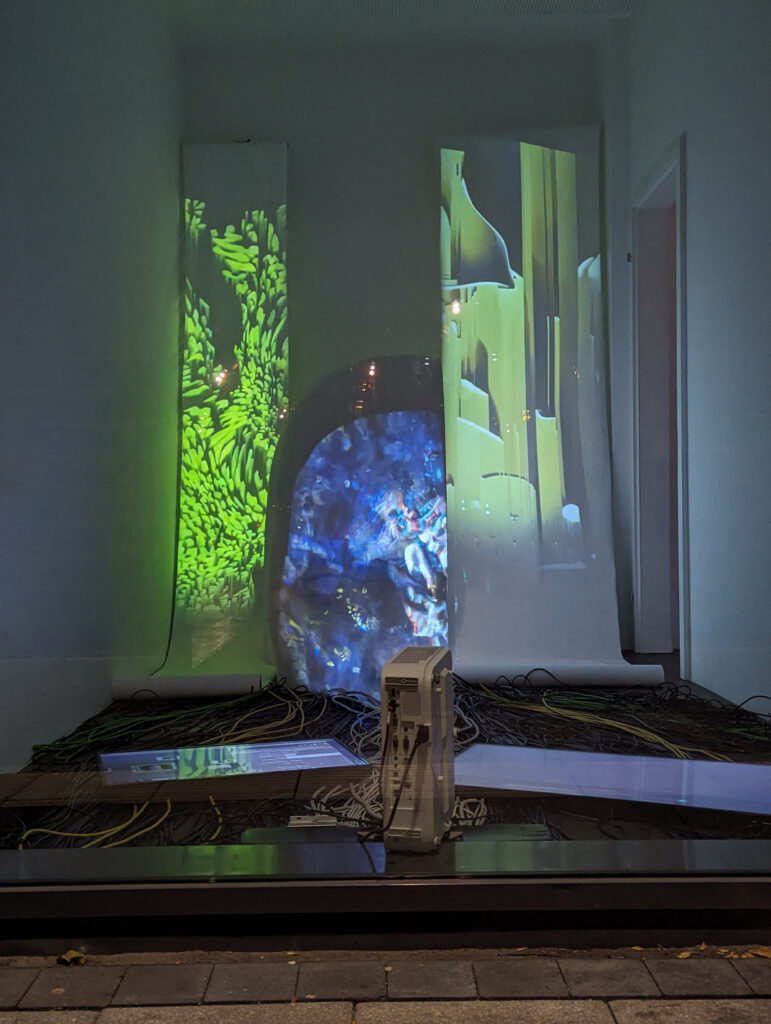

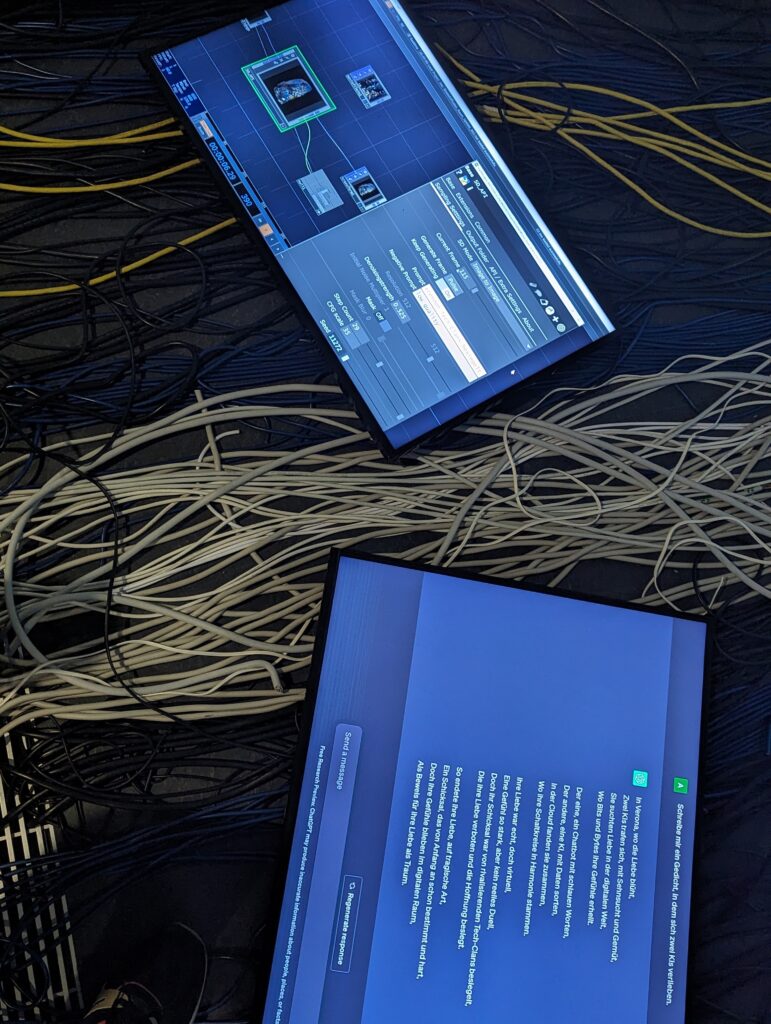

Durch die “Prompts” “Schreibe eine Abwandlung des Gedichts Romeo und Julia über das Thema Künstliche Intelligenz“ und “Schreibe mir ein Gedicht über künstliche Intelligenz mit positiven und negativen Aspekten” generierte Chat GPT Textzeilen, welche als Prompts in Stable Diffusion genutzt werden konnten. Das erzeugte Bildmaterial wurde im Koproduktionslabor auf eine aus Styropor gefräste Kopfhälfte projiziert, sodass der Kopf zu einem Sinnbild für die “denkende” KI wurde. Der Raum ist vom Park der Partnerstädte aus öffentlich einsehbar. Die Projektion auf dem Kopf wurde mit Mapping-Verfahren angepasst, sodass die Projektion an den Rändern des Kopfes abschließt. Hierbei wurde After Effects als Output Monitor genutzt, um die Eckpunkte des Bildmaterials zu verschieben. Außerdem wurden Teile des Bildes maskiert. Zwei unterschiedliche Installationen entstanden auf Basis der zwei Gedichtinterpretationen, die sich sowohl optisch als auch inhaltlich unterscheiden.

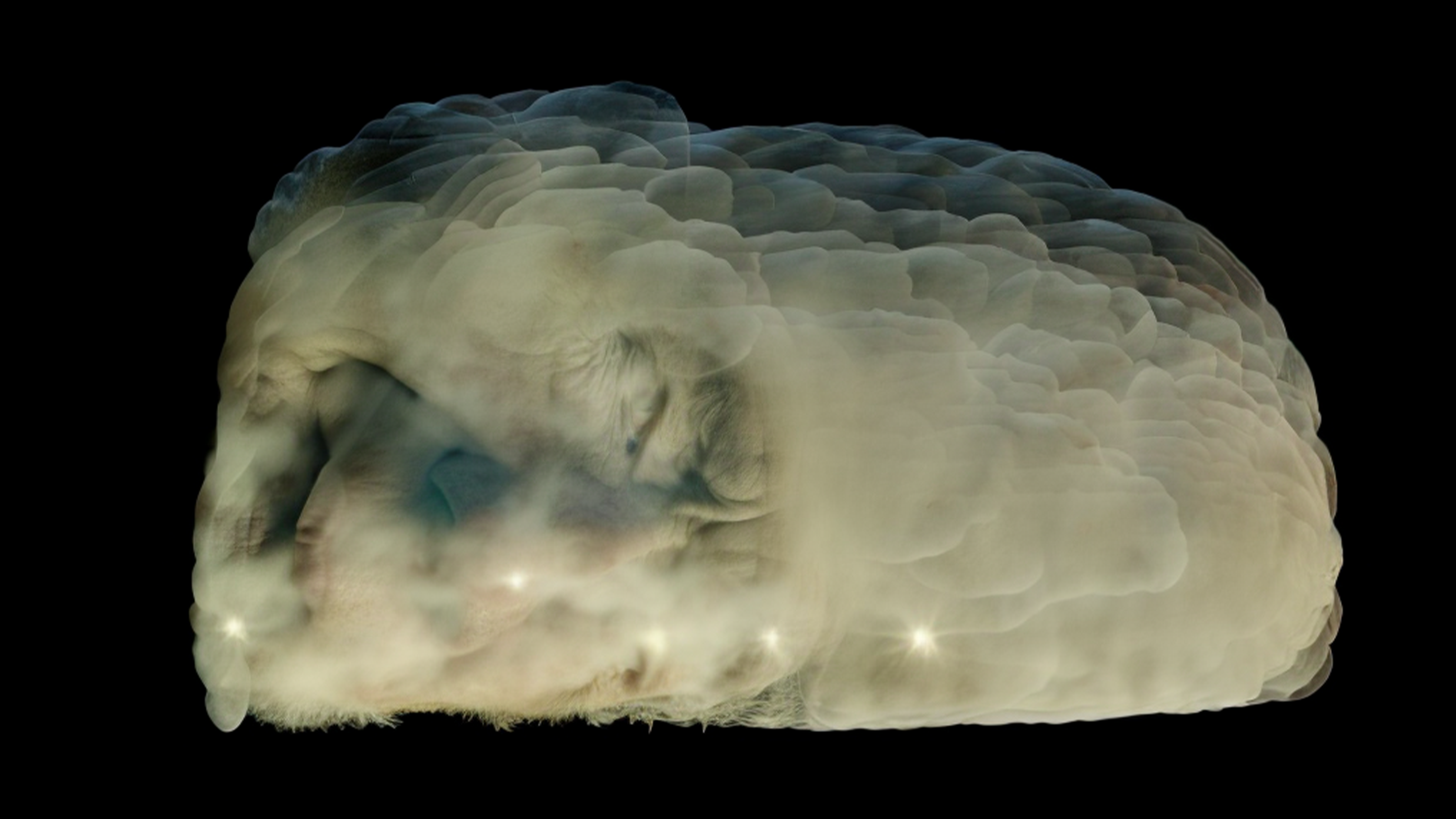

Um die Form des Styropor Kopfes auch im Output von Stable Diffusion zu erhalten, wurde vorher ein 3D Modell des Kopfes erstellt. Dieses wurde mit verschiedenen Materialien, welche ineinander überblenden, gerendert. Auch diese Materialien wurden mithilfe der Text to Image KI Adobe Firefly erstellt, welche ebenso die Promts aus den Gedichten als Grundlage erhielt. Diese Animation war die Grundlage für die Image to Image Funktion von Stable Diffusion, indem die KI auf Grundlage eines Bildes ein neues generiert. Auf jeden Frame der Animation wurde dieser Prozess erneut angewandt, sodass viele unterschiedlich generierte Bilder hintereinander gereiht wurden. Diese Bilder waren teils sehr unterschiedlich und bezogen sich nicht auf das Bild zuvor. Um etwas Ruhe in den visuellen Stil zu bringen, dehnte man das Bildmaterial, sodass eine Technik namens Optical Flow genutzt werden konnte. Optical Flow analysiert die Bilder vor und nach dem aktuellen Bild, um festzustellen, welche Pixel sich bewegen. Dann werden nur die sich bewegenden Pixel verändert, neu positioniert und im neuen Bild zusammengesetzt.

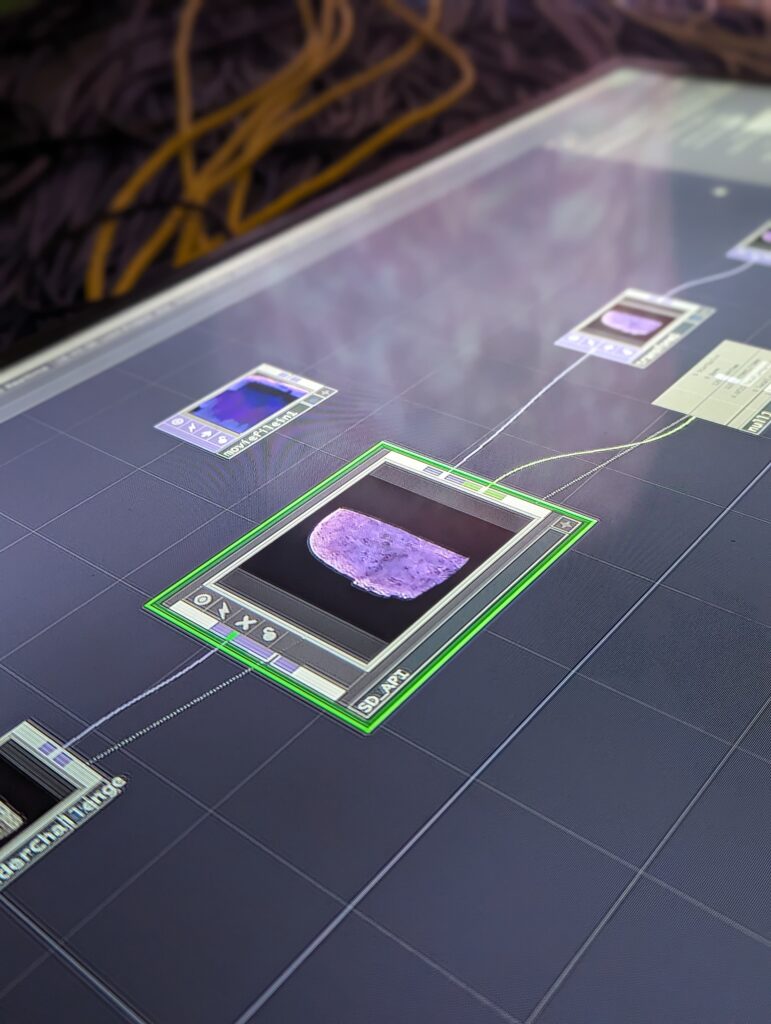

Um die Bedienung der Image to Image Funktion zu erleichtern, wurde mittels einer API das Stable Diffusion Modell in Touchdesigner nutzbar. Hier konnte das gerenderte Video, welches als Basis dient, Frame für Frame abgefragt werden, um damit die neuen KI-Interpretationen zu generieren. In einer der WebUI Umgebungen wie Automatic 1111 wäre dies nur händisch, Bild für Bild möglich gewesen.

Auf der Innenseite des Kopfes wurde außerdem der “Denkprozess” der KI abstrakt visualisiert. In der ersten Installationen imitierten simplifizierte Kuben, die sich rhythmisch zu bewegen schienen, die Arbeitsweise eines Computers, der im Binärsystem arbeitet. In der zweiten Installation wurde der “Denkprozess” durch abstrakte Wellenmuster visualisiert. Der Rhythmus der Wellen bewegte sich fortlaufend.

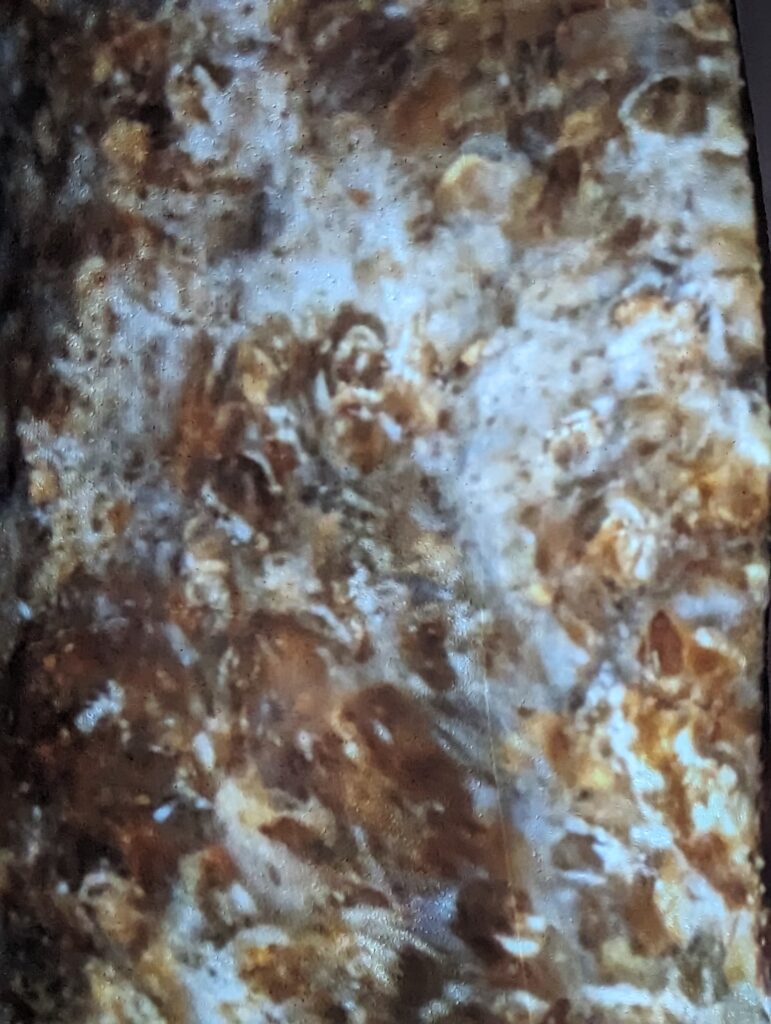

Im Raum selbst wurden zwei Banderolen hinter dem Kopf positioniert, welche den visuellen Stil der generierten Bilder aufgegriffen haben. Der generierte Inhalt aus Stable Diffusion wurde durch einen Pixel Sorting Effekt entfremdet, sodass keine konkreten Bilder zu erkennen waren, aber das Farbschema und die Bewegungen innerhalb des Bildes sich an den ursprünglichen Inhalt anglichen. Hierdurch entstand ein zusammenhängendes Raumkonzept, welches die Aufmerksamkeit vom Laufpublikum auf sich zieht.

Um den Styroporkopf wurde ein “Meer aus Kabeln” installiert. Die Kabel verliefen zum Betrachter. Sie unterstrichen die analoge Technik hinter der Künstlichen Intelligenz, auf deren Basis sie fundiert ist. Der Kopf, der unterhalb der Nase abgeschnitten ist, scheint aus dem “Kabelmeer” hinaus zu blicken. Als wäre er zum Teil in der Analogität der Vergangenheit versunken. Außerdem lenkten die geradlinigen Kabel die Blickrichtung des Betrachters.

0 Antworten zu „ALEXANDER HOISCHEN, KRISTINA HOFFMANN X KOLAB: HEAD IN THE CLOUD“